Główne trendy informatyki stosowanej

Cześć 1

W informatyce podobnie jak w innych naukach możemy wyróżnić trendy rozwoju teorii i trendy w zastosowaniach. W tym eseju naszkicowane będą główne trendy stosowanej informatyki. Z punktu widzenia zastosowań informatyka dzieli się na dwa obszary: zastosowania w naukach i inżynierii oraz zastosowania w zarzadzaniu komercjalnymi przedsiębiorstwami, które są często zwane Data Processing. Te dwa obszary zastosowań informatyki powstały już na samym początku istnienia tej nauki 70 lat temu. Nowszym zastosowaniem jest Internet i użycie komputerów do potrzeb komunikacji. W obszarze zastosowań do rozwiazywania problemów naukowych i inżynierii daje się łatwo zauważyć rozwój gałęzi informatyki zwany High Performance Computing (HPC), po polsku Wysokowydajne Obliczenia, których naprzędziecie są superkomputery. HPC opiera się na użyciu superkomputerów z wieloma procesorami, które liczą równolegle najtrudniejsze problem techniczne. HPC korzysta z najszybszych algorytmów, które mogą być liczone równolegle. Algorytmy HPC są albo klasycznymi algorytmami zmodyfikowanymi do obliczeń równoległych albo są to zupełnie nowe metody skonstruowane dla wieloprocesorowych maszyn. Sprzyjającym faktem równoległych obliczeń jest powszechne użycie algebry liniowej, która może być łatwo dostosowana do wieloprocesorowych maszyn. Szybkość technicznych obliczeń mierzy się jednostka zwana FLOPS (Flaming Point Operations per Second). Obecne najszybsze superkomputery liczą z szybkością mierzoną jednostkami noszącymi nazwę PETAFLOPs (10 do potęgi 15 FLOPs). Trzeba podkreślić ze ta olbrzymia szybkość jest wynikiem kilku faktów: równoległość obliczeń, szybkość arytmetycznych operacji, krótki dostępu do pamięci oraz nowoczesne matematyczne algorytmy. Następnym celem HPC są obliczenia 1000 razy szybsze od PETAFLOPs noszące nazwę EXAFLOPs (10 do potęgi 18 FLOPS).Odpowiedz na pytanie “Czy są nam potrzebne tak kolosalnie szybkie obliczenia jest TAK, ponieważ rozwiązujemy coraz bardziej obliczeniowo złożone problemy fizyki, astronomii, kosmologii, klimatu, teoretycznej biologii, medycyny i innych gałęzi nauki i inżynierii.

Obliczenia w przyszłości będą nie tylko wymagały więcej arytmetyki, ale będą zawierały większa dozę inteligencji. Na przykład kosmiczne sondy laboratoria musza być autonomiczne, ponieważ sterowanie i kontrola z ziemi nie jest możliwa ze względu na zbyt długi czas potrzebny na przeslanie radiowego sygnału. Na przykład robot badający chemię na księżycu Saturna musi podejmować decyzje samodzielnie bez pomocy człowieka. Radiowy sygnał z ziemi zajmuje gdzie czasu na przebycie drogi w jedna stronę. Tak wiec szybkość obliczeń i sztuczna inteligencja musza być skombinowane, aby umożliwić badanie kosmicznej przestrzeni przez roboty wysłane z Ziemi. Programy zawierające sztuczną inteligencję przydadzą się też na Ziemi. Najszybszym komputerem na świecie jest od czerwca 2018 superkomputer zwany Sunnit w Oak Ridge National Laboratory USA. Summit wykonuje 200 trylionów operacji na sekundę (trylion to 10 do potęgi 15, amerykańska nazwa quadrillion). Ta szybkość można tez określić, jako 200 Petaflops. Gdyby wszyscy żyjący ludzie świata wykonywali jedna operacje na sekundę to zajęłoby 305 dni, aby wykonać obliczenia dorównujące jednej sekundzie obliczem superkomputera Summit. Cena tej maszyny wynosi 200 milionów USD. Z punktu widzenia architektury Summit zawiera 9216 procesorów IBM, z których każdy ma 22 rdzenie. W dodatku Summit ma 27648 tzw. coprocessors, są to GPU(Graphics Processing Units) Tesla firmy ENVIDIA).

Cześć 2

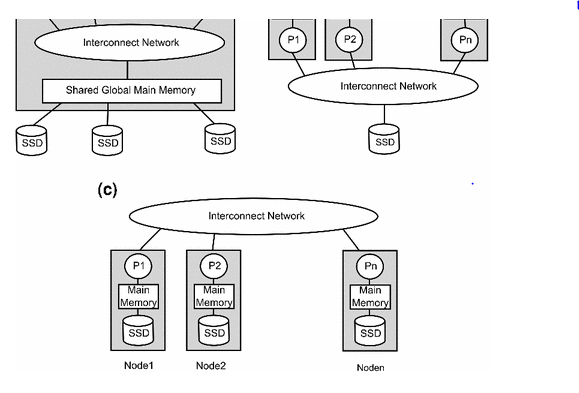

Aby opisać główny trend w obszarze data pressing trzeba przedstawić klasyczne architektury komputerów w tych zastosowaniach. Dwie architektury w górnej części rysunku przedstawiają systemy z jedna globalna pamięcią. Po prawej stronie jest to fizycznie jedna centralna pamięć a po lewej stronie pamięć jest fizycznie rozproszona, ale logicznie jedna.

Na dole obrazka jest pokazany tzw. klaster. Jest to zbiór kilku komputerów połączonych siecią. Każdy z nich ma własna lokalna pamięć. We wszystkich trzech architekturach bazy danych są umieszczone w dyskach, które są duże, ale wolne będąc elektro-mechanicznymi urządzeniami. W obszarze data pressing użytkownik formułuje pytanie i system używając danych złożonych w bazie danych liczy odpowiedz. W zależności od pytania policzenie odpowiedzi może trwać kilka sekund, kilka minut lub dłużej. W praktyce ten czas obliczeń jest na tyle długi, że nie jest możliwe interaktywne użycie systemu przez grupę analityków, którzy maja za zadanie podjęcie decyzji na podstawie analizy danych. To ograniczenie zostało ostatnio usunięte dzięki wprowadzeniu dużych szybkich pamięci, które mogą pomieścić bazy danych i maja krótki dostęp do danych. Ta zmiana zapoczątkowała trend interaktywnego użycia data pressing przez grupy decydentów firm. Jest to bardzo poważna zmiana metody zarządzania i optymalizacji decyzji. Szczegoly można znalezc w ksiazce “In-Memory Data Management, Technology and Applications” Second Edition opublikowanej przez Springer. Autorami sa Hasso Plattner i Alexander Zeier. Hasso Plattner jest popularnym ekspertem w dziedzinie data processing . Jest on zwany europejskim Billem Gates zalozycielem Microsoft.

EPILOG.

Na temat komputera kwantowego można napisać nowy esej lub nawet książkę. Zastosowanie tych maszyn będzie ograniczone. Komputer kwantowy nie zastąpi klasycznego komputera, lecz wyręczy go w rozwiazywaniu specjalnej grupy problemów, w których można liczyć równolegle miliony lub miliardy niezależnych zadań(triad). Są to bardzo trudne obliczenia dla konwencjonalnej maszyny. Większość problemów technicznych i data pressing mają ograniczoną równoległość znacznie poniżej równoległości wymaganej przez kwantowe komputery. Jednym z powodów tego, że klasyczne komputery nie zostaną wyparte przez komputery kwantowe jest olbrzymiej wartości istniejący software używany przez obecne komputery. Przeprogramowanie tych kodów wymagałoby kolosalnej ilości pieniędzy. Jest, zatem rozsądniejsze ograniczenie zastosowań kwantowych komputerów do rozwiazywania tylko najtrudniejszych problemów, które wymagają obecnie zbyt długiego czasu obliczeń. Wprowadzenie do użytku kwantowych komputerów spowoduje poważne zmiany w kryptografii (przekazywanie tajnych wiadomości), ponieważ złamanie szyfru obecnej kryptografii stanie się zbyt łatwe dla kwantowych maszyn. Mam tu na myśli powszechnie używana obecnie metodę publicznego klucza (the public key encryption RSA). Doskonałym wprowadzeniem do problemów wspolczesnej kryptografii jest książka “Cryptography and Network Security: Principles and Practice “ 7th Edition, William Stallings, 2016.

Ksiazke sprzedaje elektroniczny sklep Amazon.com

Przeczytałem z ciekawością. Tym niemniej, przypomniały mi się prognozy specjalistów z czasów, kiedy wynaleziono silnik parowy, a także rozpoczęto "podbój przestworzy" – balonami. (Nie)zapomniane pismo "Horyzonty techniki" przez długi czas zamieszczało na ostatniej stronie okładki XIX-wieczne wizje świata parowo-balonowego, co było – podobnie jak esej autora j.w. – projekcją systuacji aktualnej na przyszłość – z reguły, stety/niestety – sprawy toczyły się inaczej.

Komputer kwantowy – jako przyszłość informatyki – postrzegam na przykładzie "zimnej" fuzji termojądrowej, która już, już nadchodziła, mając być przełomem w dziedzinie energetyki. O elektrowniach termojądrowych na razie nie ma mowy – czy pociechą może być fakt, że mamy bomby wodorowe?

"Flaming point operation" brzmi bosko.

Domyslam się że nie chodzi o chirurgiczne wycinanie wrzodu, albo o gaszenie pożaru, lecz o drażnienie łechtaczki.

Oczywiscie, łechtaczke trudno zlokalizowac, jest taka płynna, wiec bardziej tu pasuje "Floating Point".

Komputer kwantowy jest kontrowersyjny. Jedni wierza ze jest tuz tuz a inni uwazaja ze nie jest osiagalny .

Jednym z problemow wprowadzenia nowej technologii komputerowej jest olbrzymi koszt przeprogramowania istniejacego sofyware.

Koszt software istniejacych komputerow to aetki miliardow dolarow w skali swiatowej. Z tego powodu komputery kwantowe nie zastapia rychlo klasyczntch.

Tym bym się nie martwił. Komputery kwantowe mają rozwiązywać inne problemy. Tzn. takie problemy, których i tak nie potrafimy dobrze rozwiązywać dziś. Nikt nie będzie przepisywał na komputer kwantowy edytora tekstu, czy centralnej ewidencji pojazdów i kierowców, bo to nie bardzo ma sens.

Komputery kwantowe jako maszyny niedeterministyczne są pomysłem na rozwiązywanie zadań trudnych w przyzwoitym czasie. Jako zadanie trudne rozumiemy problem, którego rozwiązać nie potrafimy w czasie przyzwoitym – tzn. w czasie praktycznie akceptowalnym. Komputery kwantowe mogą sprowadzić przynajmniej część z tych zadań do zadań łatwych. To brzmi zachęcająco, bo zadanie trudne to np. zadania optymalizacyjne. Może to brzmi abstrakcyjnie, ale takim zadaniem jest np. optymalizacja sieci neuronowej – dzisiaj robimy to heurystycznie albo lokalnie, a chcielibyśmy globalnie i szybko. Problemem jest fizyczna realizacja komputera kwantowego. Obecnie jest dostępne do badań zaledwie kilka komputerów kwantowych o niewielkich rejestrach.

@ZORRO.

Dobra ocena sytuacji. Komputery kwantowe i klasyczne maja w zasadzie inne przeznaczenie.Mozemy z duzym prawdop[podobienstwem przypuszczac ze oba typy maszyn beda sie wzajemnie uzupelnialy.

no przepraszam, ale jakiś baran próbuje wmówić, że janusz s. kowalik, autor m.in. "Parallel computation and computers for artificial intelligence" (https://dl.acm.org/citation.cfm?id=42549) napisał esej w którym trudno się świadomemu informatykowi dopatrzeć sensu i faktów? przecież to bzdury są na poziomie pudelka! "flaming point operations"? internet jako coś nowego (hint, internet, hypertext itp istnieją od lat '60)? "przeprogramowanie tych kodów"…? zarządzanie komercjalnymi (a co to?) przedsiębiorstwami i nauka to dwa najważniejsze trendy informatyki stosowanej, od 70 lat? WTF!?

tu racjonalnie miało być, a nie jakieś nawiedzone ściemniactwa oszustów…